前天在寫「王積薪聞棋」的PO文同時(https://reurl.cc/l0dM7v),網路上看到一則有關AI的新聞 - "Alexa首席科學家表示「圖靈測試」評量AI根本就走錯路,AI沒必要模仿人類" (https://reurl.cc/V3Xn0n)。

圖靈是上世紀的一大天才,一個人就做出改變世界命運的兩大成就。其一是二戰末期破譯德國納粹的密碼,提早讓戰爭結束;另一個是現代人工智慧理論基礎的建立,提出「圖靈測試」,看過電影『模仿遊戲』的人不會陌生。(另一個不算成就的成就,是因同性戀不見容於當時英國社會而自殺,是同志運動一再被提起的案例,若沒有早逝,資訊革命的腳步可能會提早推進若干年)

「圖靈測試」是圖靈於1950年提出的思想實驗,判斷機器是否能夠像一般人思考。方法很簡單,就是讓測試者同時向他看不到的一個人和一台機器連續發問,如果有超過30%的測試者不能確定回答的是人還是機器,那麼這台機器就通過了測試,並被認為具有人工智慧。這項測試一直被研究者視為衡量AI 是否具有「智慧」的最常用標準。

但在新聞中,Alexa 的科學家認為自我學習的機器在不如人類的地方,會用自己的長處去彌補,讓自己更像「人」,而讓測試者無從分辨。機器明明有更厲害之處,為什麼還要限制自己,去強求和人類無差別呢?那麼,我們對 AI 的衡量是不是要有新的標準?

王積薪的故事中,婆媳即使是仙人,還是以「人」的基本認知來思考棋步,但 AI 不一定要模仿人類如何思考,它有高超的運算能力和海量的資訊存儲,能夠另闢蹊徑,突破人們傳統的思維。

2016年李世乭在與 AlphaGo 的五盤人機大戰中,AlphaGo 多次以莫名其妙的落子讓李世石困惑,後來證實那些棋步是勝負的關鍵。而那些棋步違反千百年流傳下來的棋譜規律,是由AI和自己對戰的深度學習中"思索"出來,也是電腦智能科技迭代發展的成就。

我一直不認同人們的自我安慰,「人有愛心,懂得關懷,冰冷的機器學不來,所以機器永遠取代不了人類」。真是屁話,人類縱使有七情六慾,可預見對於神通廣大的 AI 來說,以有窮盡的參數模擬起來並不是很難,甚至可能大大超越人類的情感變化,發展出人類想不到的「愛」與「關懷」,人類一方可獲得更溫暖的回應。

在速度的比拚上,人類早已落後汽車很多,人們頂多在自身領域拿個奧運金牌。那未來人們在 AI 掌控的時代還可以做什麼呢?人的意義又何在?

另一個讓我嗤之以鼻的常見無聊論戰是爭辯哪一個行業的人比較容易失業?製造業還是服務業?醫師還是護理員?銀行櫃檯員還是理專?麥當勞得來速還是炸薯條的員工?在未來典範轉移時,現在所有的工作型態都需要重新的思考,所有職業都有可能消失,但部分會轉換成不同的方式,也會有很多現今尚未存在的工作出現。

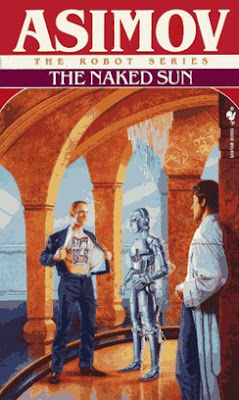

科幻大師艾西莫夫早在1957的機器人系列--《裸陽》中,就有一個叫做索拉利的人類移居星球,當地居民的生活起居都由機器人打點,人們只要負責藝術、玩樂和縱慾。歷史學家哈拉瑞在《21是記的21堂課》提到「全民基本收入(UBI)」的觀念,政府應該對控制演算法和機器人的億萬富豪和企業課稅,在用這筆稅金滿足所有人的基本需求。例如給又窮又失業的極端正統猶太人天天研究猶太經典《塔木德》,雖然毫無生產力,但他們會因此得到歡樂和滿足,這不也是人生的意義嗎?

一般大公司除了有CEO(執行長)、CFO(財務長)、CTO(技術長)以外,可能還需要哲學長(Chief Philosophical Officer,CPO),確定 AI 系統的行動符合倫理規範。思辨的重要課題「電車問題」即為一例,發生事故時你可不可以犧牲一個無辜第三者而救一整車的人?在自動駕駛車的場景,狀況為救車上的X人,可能會撞上路旁行人Y人,那CPO要思考如何設定 AI 的核心判斷,X和Y的比例要多少才不會背離道德準則?

更近一步想,CPO可以是AI 嗎?人類的思維可以限制住 AI 嗎?再多想是科幻電影的範圍了。

或許像下棋一樣的「弱人工智慧」只能在預先定義的問題範圍內運作,而我們距離「強人工智慧」(「通用人工智慧」),還有好幾十年,甚至百年以上的距離。但說不定,正如搞失蹤的馬雲說的:未來已來。